Click 如何调用 Command 函数并取得返回值

在项目的演进过程中,都会经历项目需求从少至多,由简单到复杂的过程。在这个不停追加的过程中,项目结构也会从一个小脚本就能搞定变化到需要由几个小脚本配合共同支撑,项目的代码也会从精简干练慢慢变到冗余、重合度高。

这时候,为了让项目结构更加稳健,易用性更高,可读性更好,是需要重建程序入口,把脚本工程化的。

看起来很复杂,实际上就是在项目演进的不同阶段适时地重构,每个优秀的项目都是经过千(多)锤(次)百(重)炼(构)才能形成的。

今天就从程序的入口开始,记录一次改造。(中间省略 1000 字为重构的细节及方法…)

在最初的版本,程序入口直接使用了简单粗暴的 if - else,带来的问题就是,无论如何封装抽象,都无法改变可读性极差的结果。于是在无力演进的情况下,选择一款 CLI 构建工具,提高可持续性,防止自己重造车轮。

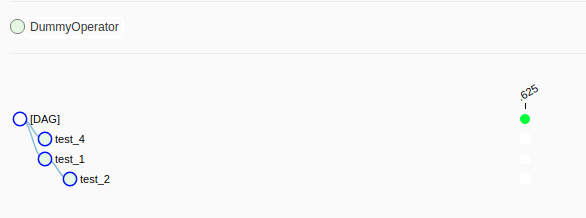

CLI 构建工具 Click

Click 的基础使用方法和高级特性都可以从官方文档获取

以下谨记录个人使用到的,以及我认为最常用的操作。

基本用法

夏天来了,案例使用了冰淇淋,这样看起来会清凉一些。

1 | import click |